La inteligencia artificial desembarca en el campo de batalla y despierta terror con los “robots asesinos”

Las potencias avanzan en el desarrollo de dotar cada vez de más autonomía a sus sistemas de armamentos, con el riesgo de dejarlos tomar todas las decisiones

Con la llegada de la inteligencia artificial (IA) al campo de batalla, las máquinas van a poder tomar decisiones por su cuenta sobre qué tanques destruir, qué barcos hundir y qué aviones derribar, entre otros blancos. Por un lado, pueden ser a la vez más precisas y ahorrar daños colaterales. Por el otro, no son infalibles y pueden salirse de control. De cualquier manera, las máquinas vienen marchando.

Y mientras los ingenieros se unen a los generales para sacar partido de la tecnología, diseñar prototipos y lanzarlos al terreno, otros observadores llaman a concertar una legislación que brinde cierto marco, de modo que las máquinas no se corten por su cuenta. Sobre todo, quieren que los sistemas cumplan con una de las leyes de la robótica de Isaac Asimov: no matarás humanos.

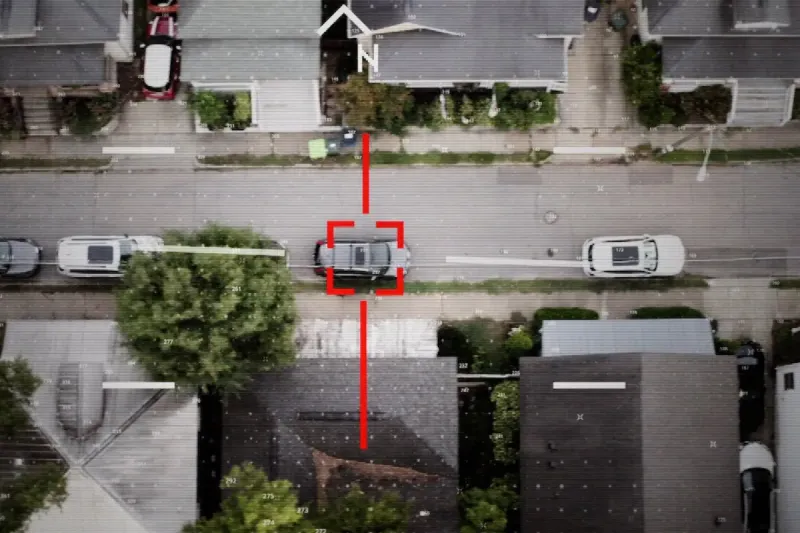

Según la definición del Comité Internacional de la Cruz Roja, las armas autónomas que desarrollan los laboratorios de las grandes potencias, conocidas popularmente como “killer robots”, son sistemas que seleccionan y aplican la fuerza sin intervención humana. Si bien estos sistemas ya estaban en danza, la evolución de la IA tiene el potencial de liberarlos de sus últimas ataduras.

“En lo que se ha dado en llamar la militarización de la inteligencia artificial y en el campo de batalla, su uso ofrece una potencial ventaja en cuanto a la evaluación de la situación, debido a la gran cantidad de información que puede recoger y procesar y las decisiones pueden ser mucho más rápidas, y si los datos son buenos, más precisas. El mayor riesgo está en la completa autonomía de las armas”, dice a LA NACION Pía Devoto, coordinadora de la Red de Seguridad Humana en América Latina y el Caribe (Sehlac).

“Luego de una activación inicial o lanzamiento por una persona, el sistema de autoinicia y desencadena un ataque en respuesta a la información recibida del entorno a través de sensores de acuerdo al objetivo para el cual ha sido programada. Eso quiere decir que el usuario no elige el momento o el lugar en la que la fuerza va a ser utilizada y tampoco puede desactivarlo”, agrega.

Los sistemas van adquiriendo la capacidad de tomar decisiones para localizar, perseguir y disparar a su juicio. Y también, desde el cuartel general, otros sistemas podrían trazar estrategias y ordenar ataques. Máquinas hablando con máquinas. ¿Pero en qué etapa de desarrollo se encuentra la tecnología de IA en la guerra? ¿Cuánto de autónomas tienen las armas autónomas?

Ventaja decisiva

Estados Unidos, China y Rusia se frotan las manos y le dedican millones de dólares, yuanes y rublos a esta industria en desarrollo, con la que esperan avanzar a grandes pasos y lograr una ventaja decisiva sobre sus rivales y actores menores. También lo hacen Corea del Sur y la Unión Europea (UE). A su vez, algunos de estos actores menores, como Turquía e Irán, quieren su lugar bajo el sol y buscan su nicho en la prometedora tecnología.

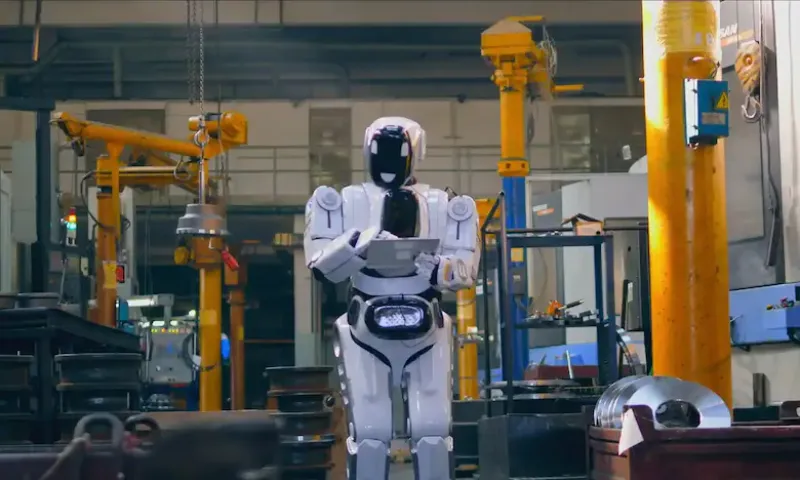

“Algunos de los sistemas están diseñados para volar, conducir o sumergirse, recopilar información de inteligencia, atacar por sí solos objetivos designados o entregar suministros. Pero siempre obtienen sus misiones, objetivos y autorizaciones de un humano”, escribió al respecto Maximiliam Schreiner, editor de The Decoder, un sitio especializado en la inteligencia artificial.

“La Fuerza Aérea de Estados Unidos, por ejemplo, probó variantes del XQ-58A de Kratos como parte del Programa Skyborg. Se supone que los drones furtivos son económicos y vuelan junto a un piloto humano, recibiendo órdenes de él y proporcionando una plataforma de apoyo para el reconocimiento y las armas”, precisó.

Un informe de 2021 de Amnesty International advertía sobre las fuertes inversiones de las potencias en el desarrollo de sistemas armados autónomos. Gran Bretaña, por ejemplo, trabajaba en el desarrollo de drones que podrían identificar un blanco dentro de un área programada, mientras que Rusia construyó un tanque robot que se puede equipar con una ametralladora o un lanzagranadas.

Enjambres y submarinos

La industria armamentista china también presiona por el desarrollo de esta tecnología, que incluye los drones Blowfish A2 que pueden volar en enjambres y atacar un objetivo de manera independiente. También aspira a desarrollar robots sumergibles autónomos.

James Dawes, quien ha escrito extensamente sobre los sistemas autónomos, señaló en Fortune que el Departamento de Defensa de Estados Unidos presentó en enero una directiva centrada en el desarrollo de la IA para uso militar. Venía a continuación de un proyecto de la OTAN de octubre de 2022, donde apuntaba a preservar la “ventaja tecnológica” de la alianza en esa materia.

“Las fuerzas que no estén respaldadas por la IA aplastarán y destruirán absolutamente a las fuerzas que no lo estén”, dice un entrevistado en el documental Unknown, killer robots que Netflix estrenó este año. Allí se ve la brecha entre quienes cantan loas a la capacidad de las máquinas de destruir por su cuenta, y quienes llaman a meditar las consecuencias antes de seguir como aprendices de brujo. “Si no se usa con sabiduría, presenta un grave riesgo a cada persona del planeta”, dice otra fuente.

Espectadores

Si se profundiza la autonomía, pronto los militares seguirán las guerras como quien sigue una serie de televisión, siendo meros espectadores. Por eso el Comité Internacional de la Cruz Roja insiste en que la responsabilidad de comandantes no es transferible. “Los riesgos son humanitarios, legales y éticos”, dice Pía Devoto. “No se le puede dejar a un algoritmo la decisión sobre la vida y la muerte”.

Lo más cercano a las guerras robotizadas que se vio hasta el momento se sabe a partir de un informe de la ONU, donde sugiere que drones de fabricación turca Kargu-2 en modo totalmente automático marcaron el inicio de la nueva era, al atacar a combatientes en Libia en medio de la guerra civil de ese enorme país del norte de África.

También se han usado drones con cierta vida propia en la guerra en Ucrania -los dos bandos-, aunque los informes se contradicen sobre su grado de autonomía. “A medida que aumentan las bajas en Ucrania, también lo hace la presión para alcanzar una ventaja decisiva en el campo de batalla con robots totalmente automatizados que puedan elegir, perseguir y atacar sus objetivos por su cuenta, sin necesidad de supervisión humana”, dijo Dawes.

Eso es lo que organizaciones como Human Rights Watch y la campaña Stop Killer Robots quieren evitar. Alegan que los sistemas autónomos no tienen el suficiente juicio para distinguir entre civiles y legítimos objetivos militares. También señalan que reducen la percepción de riesgo y erosionan el control humano sobre lo que sucede en el campo de batalla. Y los nuevos sistemas, por si fuera poco, tampoco han sido infalibles, rebatiendo el argumento de que la extrema precisión de las máquinas ahorrará vidas.

La OTAN y el Pentágono afirmaron que los sistemas autónomos deben seguir bajo supervisión, y que no pretenden la independencia absoluta de las máquinas. Pero como sucede con la IA en la vida civil, existen dudas de qué pasará una vez que el genio salga de la botella. Y también están los chinos y rusos. Ya dijo Vladimir Putin, en 2017, que quien domine la inteligencia artificial, dominará el mundo.